आप जितना सोचते हैं उससे अधिक खोज इंजन पर आपका नियंत्रण है।

यह सत्य है; आप हेरफेर कर सकते हैं जो आपकी साइट को क्रॉल और इंडेक्स करता है - यहां तक कि अलग-अलग पेजों तक भी। इसे नियंत्रित करने के लिए, आपको robots.txt फ़ाइल का उपयोग करना होगा। Robots.txt एक साधारण टेक्स्ट फ़ाइल है जो आपकी वेबसाइट के रूट डायरेक्टरी में रहती है। यह खोज इंजनों द्वारा भेजे जाने वाले रोबोटों को सूचित करता है कि कौन से पृष्ठ क्रॉल करने के लिए हैं और कौन से अनदेखी करने के लिए।

हालांकि बिलकुल भी नहीं है, और आप सभी का ध्यान रखते हैं, आप शायद यह समझ गए हैं कि यह काफी शक्तिशाली उपकरण है और आपको अपनी वेबसाइट को Google में इस तरह पेश करने की अनुमति देगा कि आप उन्हें देखना चाहते हैं। खोज इंजन चरित्र के कठोर न्यायाधीश हैं, इसलिए एक महान प्रभाव बनाने के लिए आवश्यक है। Robots.txt, जब सही तरीके से उपयोग किया जाता है, तो क्रॉल आवृत्ति में सुधार हो सकता है, जो आपके एसईओ प्रयासों को प्रभावित कर सकता है।

तो, आप एक कैसे बनाते हैं? आप इसका इस्तेमाल कैसे करते हैं? आपको किन चीजों से बचना चाहिए? इन सभी सवालों के जवाब जानने के लिए इस पोस्ट को देखें।

एक Robots.txt फ़ाइल क्या है?

जब इंटरनेट सिर्फ एक बच्चे का सामना करने वाला बच्चा था, जो महान चीजें करने की क्षमता के साथ था, डेवलपर्स ने वेब पर ताजा पृष्ठों को क्रॉल और इंडेक्स करने का एक तरीका तैयार किया। उन्होंने इन 'रोबोट' या 'मकड़ियों' को बुलाया।

कभी-कभी ये छोटे-छोटे फ़ॉल्स उन वेबसाइटों पर भटक जाते हैं जिनका उद्देश्य रेंगना और अनुक्रमित करना नहीं था, जैसे कि रखरखाव से गुजरने वाली साइटें। दुनिया के पहले खोज इंजन के निर्माता, अलीवेब ने एक समाधान की सिफारिश की - एक प्रकार का रोड मैप, जिसका प्रत्येक रोबोट को पालन करना चाहिए।

इस रोडमैप को इंटरनेट-प्रेमी तकनीक के संग्रह द्वारा 1994 में " रोबोट एक्सक्लूज़न प्रोटोकॉल " के रूप में अंतिम रूप दिया गया था ।

एक robots.txt फ़ाइल इस प्रोटोकॉल का निष्पादन है। प्रोटोकॉल उन दिशानिर्देशों को चित्रित करता है जिनका पालन हर प्रामाणिक रोबोट को करना चाहिए, जिसमें Google बॉट भी शामिल है। कुछ नाजायज रोबोट, जैसे कि मालवेयर, स्पाईवेयर, और जैसे, परिभाषा के अनुसार, इन नियमों के बाहर काम करते हैं।

आप किसी भी URL में टाइप करके और अंत में: /robots.txt जोड़कर किसी भी वेबसाइट के पर्दे के पीछे एक तिरछी नज़र रख सकते हैं।

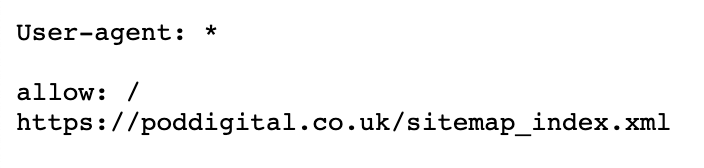

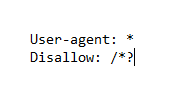

उदाहरण के लिए, यहाँ POD डिजिटल का संस्करण:

जैसा कि आप देख सकते हैं, ऑल-सिंगिंग, ऑल-डांसिंग फाइल होना आवश्यक नहीं है क्योंकि हम एक अपेक्षाकृत छोटी वेबसाइट हैं।

कहाँ Robots.txt फ़ाइल का पता लगाएँ

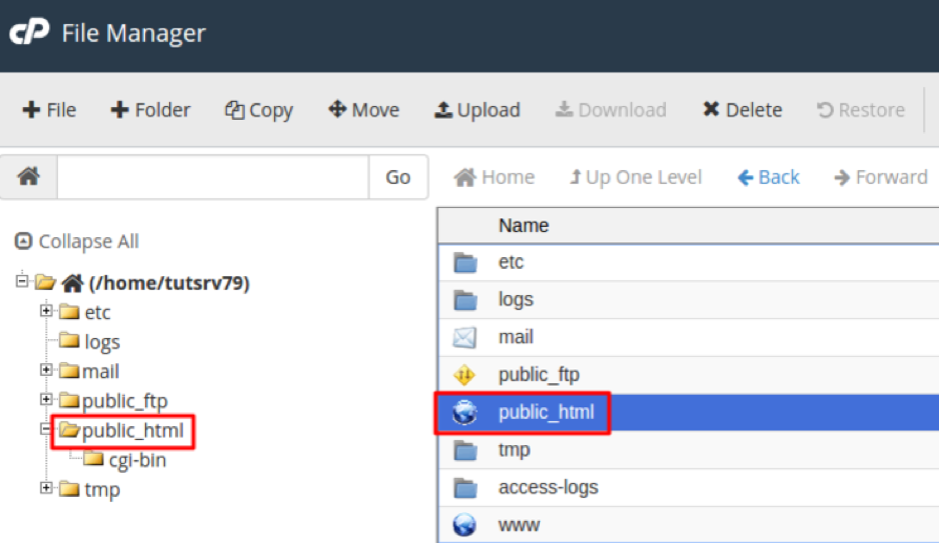

आपकी robots.txt फ़ाइल को आपकी साइट की मूल निर्देशिका में संग्रहीत किया जाएगा। इसे खोजने के लिए, अपना FTP cPanel खोलें , और आप फ़ाइल को अपनी public_html वेबसाइट निर्देशिका में ढूंढ पाएंगे।

इन फ़ाइलों के लिए कुछ भी नहीं है ताकि वे भारी नहीं होंगे - शायद केवल कुछ सौ बाइट्स, यदि वह।

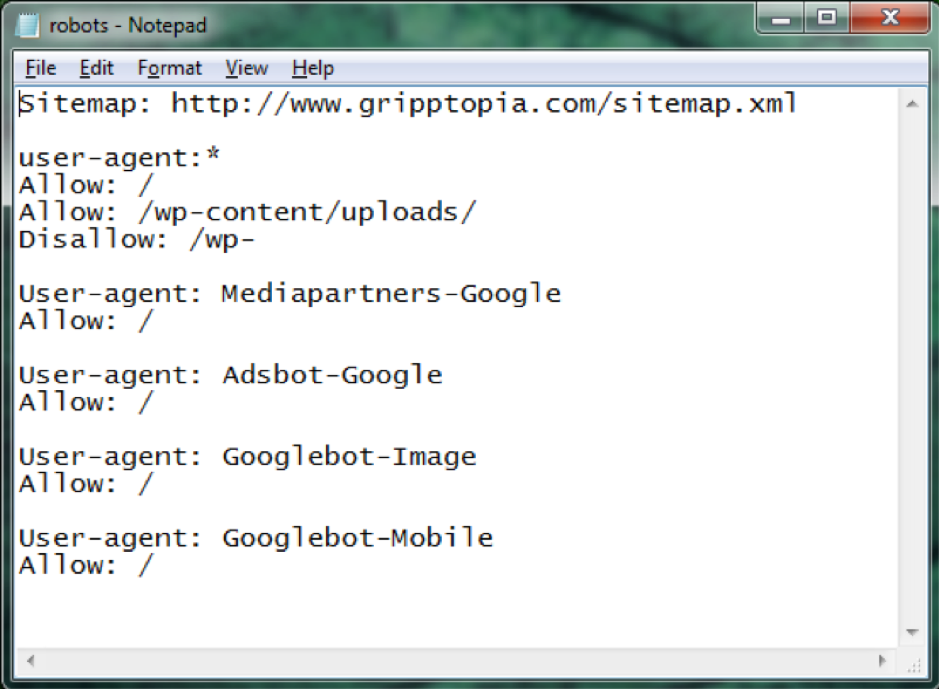

एक बार जब आप अपने पाठ संपादक में फ़ाइल खोलते हैं, तो आपको कुछ इस तरह से बधाई दी जाएगी:

यदि आप अपनी साइट के आंतरिक कामकाज में एक फ़ाइल नहीं ढूंढ पा रहे हैं, तो आपको अपना स्वयं का बनाना होगा।

कैसे एक साथ डाल करने के लिए एक Robots.txt फ़ाइल

Robots.txt एक सुपर बेसिक टेक्स्ट फ़ाइल है, इसलिए यह वास्तव में बनाने के लिए सीधी है। आपको बस नोटपैड की तरह एक साधारण टेक्स्ट एडिटर की आवश्यकता होगी। एक शीट खोलें और खाली पेज को 'robots.txt' के रूप में सहेजें।

अब अपने cPanel में लॉगिन करें और साइट की रूट डाइरेक्टरी तक पहुँचने के लिए public_html फोल्डर खोजें। एक बार जो ओपन हो जाए, उसमें अपनी फाइल को ड्रैग करें।

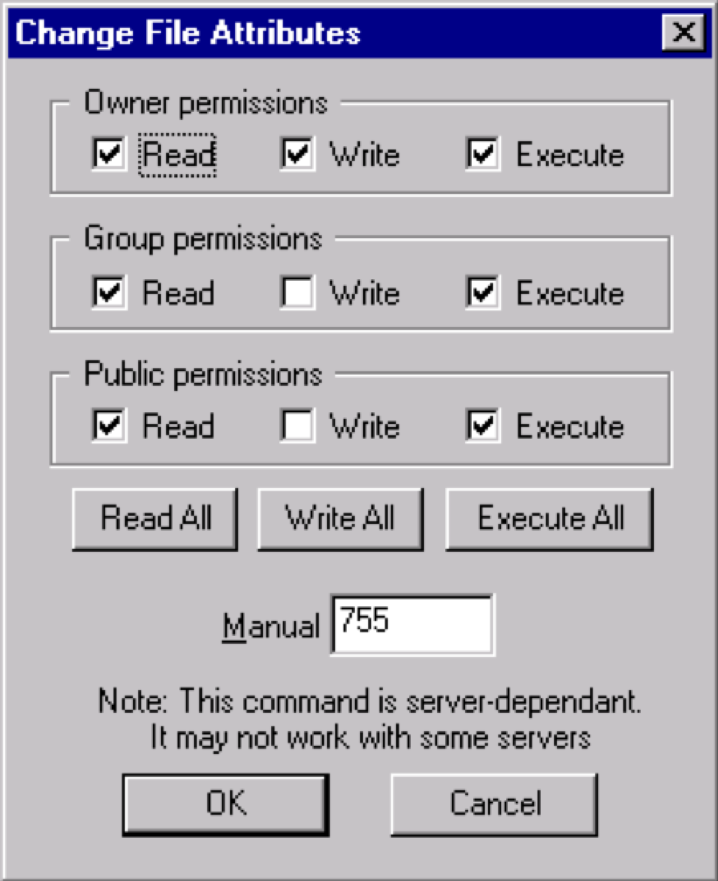

अंत में, आपको यह सुनिश्चित करना होगा कि आपने फ़ाइल के लिए सही अनुमति निर्धारित की है। मूल रूप से, स्वामी के रूप में, आपको फ़ाइल लिखना, पढ़ना और संपादित करना होगा, लेकिन किसी अन्य पक्ष को ऐसा करने की अनुमति नहीं दी जानी चाहिए।

फ़ाइल को "0644" अनुमति कोड प्रदर्शित करना चाहिए।

यदि नहीं, तो आपको इसे बदलने की आवश्यकता होगी, इसलिए फ़ाइल पर क्लिक करें और "फ़ाइल अनुमति" चुनें।

देखा! आपके पास Robots.txt फाइल है।

Robots.txt सिंटेक्स

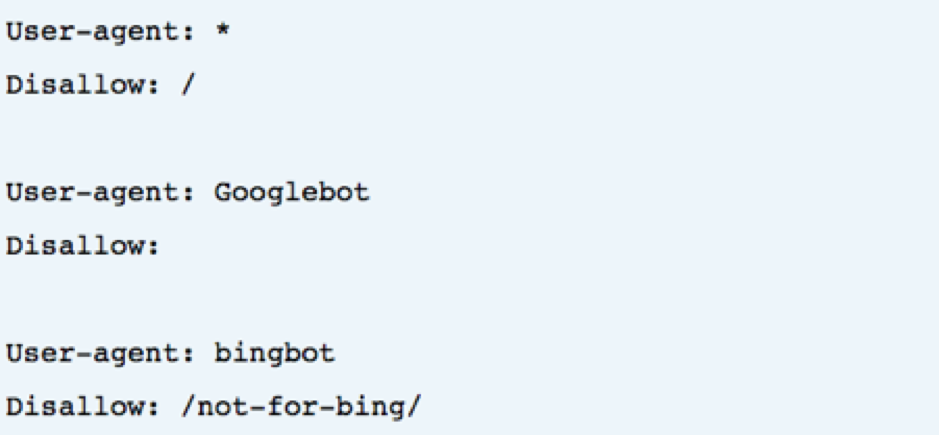

एक रोबो.टैक्स फ़ाइल 'निर्देशों ’के कई खंडों से बनी है, प्रत्येक शुरुआत एक निर्दिष्ट उपयोगकर्ता-एजेंट के साथ होती है। उपयोगकर्ता एजेंट उस विशिष्ट क्रॉल बॉट का नाम है जिसे कोड बोल रहा है।

दो विकल्प उपलब्ध हैं:

- आप एक साथ सभी खोज इंजनों को संबोधित करने के लिए वाइल्डकार्ड का उपयोग कर सकते हैं ।

- आप विशिष्ट खोज इंजनों को व्यक्तिगत रूप से संबोधित कर सकते हैं।

जब किसी वेबसाइट को क्रॉल करने के लिए एक बॉट तैनात किया जाता है, तो यह उन ब्लॉकों को आकर्षित किया जाएगा जो उन्हें कॉल कर रहे हैं।

यहाँ एक उदाहरण है:

उपयोगकर्ता-एजेंट का निर्देश

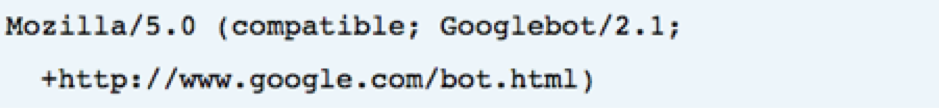

प्रत्येक ब्लॉक में पहली कुछ पंक्तियाँ 'उपयोगकर्ता-एजेंट' हैं, जो एक विशिष्ट बॉट को पिन करती हैं। उपयोगकर्ता-एजेंट एक विशिष्ट बॉट्स नाम से मेल खाएगा, इसलिए उदाहरण के लिए:

इसलिए यदि आप एक Googlebot को बताना चाहते हैं कि उदाहरण के लिए, क्या करना है:

उपयोगकर्ता-एजेंट: Googlebot

खोज इंजन हमेशा विशिष्ट निर्देशों को इंगित करने का प्रयास करते हैं जो उनसे सबसे अधिक निकटता से संबंधित हैं।

इसलिए, उदाहरण के लिए, यदि आपको दो निर्देश मिले हैं, एक Googlebot-Video के लिए और एक Bingbot के लिए। उपयोगकर्ता-एजेंट 'बिंगबॉट' के साथ आने वाला एक बॉट निर्देशों का पालन करेगा। जबकि 'Googlebot-Video' बॉट इस पर से गुजरेगा और अधिक विशिष्ट निर्देश की तलाश में जाएगा।

मेज़बान निर्देशक

मेजबान निर्देश फिलहाल केवल यैंडेक्स द्वारा समर्थित है, भले ही कुछ अटकलें कहती हैं कि Google इसका समर्थन करता है। यह निर्देश उपयोगकर्ता को यह तय करने की अनुमति देता है कि क्या www को दिखाना है। इस ब्लॉक का उपयोग करने वाले URL से पहले:

होस्ट: poddigital.co.uk

चूंकि यांडेक्स निर्देशन का एकमात्र पुष्टि समर्थक है, इसलिए उस पर भरोसा करना उचित नहीं है। इसके बजाय, 301 उन होस्टनामों को पुनर्निर्देशित करते हैं, जिन्हें आप नहीं करते हैं।

निर्देश को अस्वीकार करें

हम इसे थोड़े समय बाद और अधिक विशिष्ट तरीके से कवर करेंगे।

निर्देशों के एक ब्लॉक में दूसरी पंक्ति अस्वीकृत है। आप इसका उपयोग यह निर्दिष्ट करने के लिए कर सकते हैं कि साइट के किन हिस्सों को बॉट्स द्वारा एक्सेस नहीं किया जाना चाहिए। खाली डिस्लो का मतलब है कि यह सभी के लिए एक मुफ्त है, और बॉट खुद को खुश कर सकते हैं कि वे कहाँ जाते हैं और क्या नहीं करते हैं।

साइटमैप निर्देश (XML साइटमैप)

साइटमैप निर्देश का उपयोग खोज इंजन को बताता है कि आपके XML साइटमैप को कहां खोजें ।

हालाँकि, शायद सबसे उपयोगी बात यह है कि हर एक को सर्च इंजन के विशिष्ट वेबमास्टर टूल्स में जमा करना होगा। ऐसा इसलिए है क्योंकि आप अपनी वेबसाइट के बारे में प्रत्येक से बहुत सी मूल्यवान जानकारी सीख सकते हैं।

हालांकि, यदि आप समय पर कम हैं, तो साइटमैप निर्देश एक व्यवहार्य विकल्प है।

क्रॉल-देरी निर्देश

रेंगने की बात आने पर याहू, बिंग और यैंडेक्स थोड़ा खुश हो सकते हैं, लेकिन वे क्रॉल-देरी निर्देश का जवाब देते हैं, जो उन्हें थोड़ी देर के लिए खाड़ी में रखता है।

इस लाइन को अपने ब्लॉक में लागू करना:

क्रॉल-देरी: 10

इसका मतलब है कि आप खोज इंजन को साइट पर रेंगने से दस सेकंड पहले प्रतीक्षा कर सकते हैं या रेंगने के बाद साइट पर पहुंचने से दस सेकंड पहले - यह मूल रूप से समान है, लेकिन खोज इंजन के आधार पर थोड़ा अलग है।

क्यों Robots.txt का उपयोग करें

अब जब आप मूल बातें जानते हैं और कुछ निर्देशों का उपयोग कैसे करते हैं, तो आप अपनी फ़ाइल को एक साथ रख सकते हैं। हालाँकि, यह अगला चरण आपकी साइट की सामग्री के प्रकार पर आ जाएगा।

Robots.txt एक सफल वेबसाइट के लिए एक आवश्यक तत्व नहीं है; वास्तव में, आपकी साइट अभी भी सही ढंग से काम कर सकती है और एक के बिना अच्छी तरह से रैंक कर सकती है।

हालाँकि, इससे पहले कि आप इसे खारिज कर दें, इसके कई महत्वपूर्ण लाभ हैं:

- निजी फ़ोल्डरों से दूर बिंदु बॉट : अपने निजी फ़ोल्डरों की जाँच से बॉट्स को रोकना उन्हें खोजने और अनुक्रमणिका के लिए बहुत कठिन बना देगा।

- संसाधनों को नियंत्रण में रखें : हर बार जब कोई बॉट आपकी साइट के माध्यम से क्रॉल करता है, तो यह बैंडविड्थ और अन्य सर्वर संसाधनों को बेकार कर देता है। टन सामग्री और बहुत सारे पृष्ठों वाली साइटों के लिए, ई-कॉमर्स साइटें, उदाहरण के लिए, हजारों पृष्ठ हो सकते हैं, और इन संसाधनों को वास्तव में जल्दी से सूखा जा सकता है। आप बोट्स के लिए अलग-अलग स्क्रिप्ट्स और इमेज को एक्सेस करना मुश्किल बनाने के लिए robots.txt का उपयोग कर सकते हैं; यह असली आगंतुकों के लिए मूल्यवान संसाधनों को बनाए रखेगा।

- अपने साइटमैप का स्थान निर्दिष्ट करें : यह एक महत्वपूर्ण बिंदु है, आप क्रॉलर्स को यह बताना चाहते हैं कि आपका साइटमैप कहां स्थित है, इसलिए वे इसके माध्यम से स्कैन कर सकते हैं।

- SERPs से डुप्लीकेट कंटेंट को दूर रखें : अपने रोबोट में नियम जोड़कर, आप क्रॉलर को उन अनुक्रमण पृष्ठों से रोक सकते हैं जिनमें डुप्लिकेट सामग्री होती है।

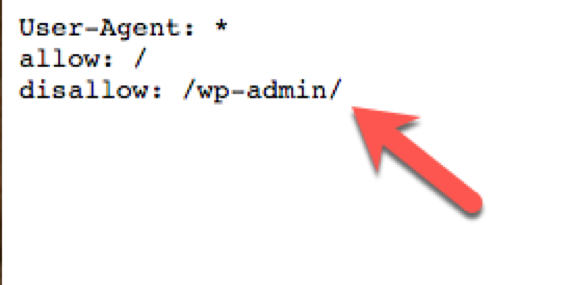

आप स्वाभाविक रूप से खोज इंजन को अपनी वेबसाइट के सबसे महत्वपूर्ण पन्नों तक उनका रास्ता खोजना चाहेंगे। विशिष्ट पृष्ठों से विनम्रतापूर्वक तारबंदी करके, आप यह नियंत्रित कर सकते हैं कि खोजकर्ताओं के सामने कौन से पृष्ठ हैं ( निश्चित पृष्ठों को देखने से खोज इंजनों को कभी भी पूरी तरह से अवरुद्ध नहीं करना सुनिश्चित करें )।

उदाहरण के लिए, यदि हम POD डिजिटल रोबोट फ़ाइल को देखते हैं, तो हम देखते हैं कि यह URL:

poddigital.co.uk/wp-admin को रोक दिया गया है।

चूँकि वह पृष्ठ हमारे लिए नियंत्रण कक्ष में प्रवेश करने के लिए बना है, इसलिए बॉट्स को अपना समय बर्बाद करने और उसे रेंगने की अनुमति देने का कोई मतलब नहीं है।

नोइंडेक्स

जुलाई 2019 में, Google ने घोषणा की कि वे नोइंडेक्स निर्देश के साथ-साथ कई पहले से असमर्थित और अप्रकाशित नियमों का समर्थन करना बंद कर देंगे जो हम में से कई पहले से भरोसा कर चुके हैं।

हम में से कई ने नोइंडेक्स निर्देश को लागू करने के लिए वैकल्पिक तरीकों की तलाश करने का फैसला किया, और नीचे आप कुछ विकल्प देख सकते हैं जो आप इसके बजाय जाने का फैसला कर सकते हैं:

- Noindex Tag / Noindex HTTP Response Header: इस टैग को दो तरह से लागू किया जा सकता है, पहला होगा एक X- रोबोट-टैग के साथ HTTP प्रतिक्रिया हेडर के रूप में या एक <meta> टैग बनाने के लिए जिसे <i> के भीतर लागू करना होगा। अनुभाग।

आपका <मेटा> टैग नीचे दिए गए उदाहरण की तरह दिखना चाहिए: <मेटा नाम = "रोबोट" सामग्री = "नोइंडेक्स">

TIP : यह ध्यान रखें कि यदि इस पेज को robots.txt फ़ाइल द्वारा ब्लॉक किया गया है, तो क्रॉलर को आपका noindex टैग कभी नहीं दिखाई देगा, और अभी भी एक मौका है कि इस पृष्ठ को SERPs के भीतर प्रस्तुत किया जाएगा।

- पासवर्ड सुरक्षा: Google बताता है कि ज्यादातर मामलों में, यदि आप एक लॉगिन के पीछे एक पृष्ठ छिपाते हैं, तो उसे Google के सूचकांक से हटा दिया जाना चाहिए। एकमात्र अपवाद प्रस्तुत किया जाता है यदि आप स्कीमा मार्कअप का उपयोग करते हैं, जो इंगित करता है कि पृष्ठ सदस्यता या भुगतान की गई सामग्री से संबंधित है ।

- 404 और 410 HTTP स्थिति कोड: 404 और 410 स्थिति कोड उन पृष्ठों का प्रतिनिधित्व करते हैं जो अब मौजूद नहीं हैं। एक बार 404/410 स्टेटस वाला पेज क्रॉल और पूरी तरह से प्रोसेस होने के बाद, इसे Google के इंडेक्स से अपने आप हटा देना चाहिए।

404 और 410 त्रुटि पेज होने के जोखिम को कम करने के लिए आपको अपनी वेबसाइट को व्यवस्थित रूप से क्रॉल करना चाहिए और जहां मौजूदा पेज पर ट्रैफिक को रीडायरेक्ट करने के लिए 301 रीडायरेक्ट का उपयोग करने की आवश्यकता होती है।

- Robots.txt में नियम को अस्वीकार करें: अपनी robots.txt फ़ाइल में एक पृष्ठ विशिष्ट अस्वीकृत नियम जोड़कर, आप खोज इंजन को पृष्ठ क्रॉल करने से रोकेंगे। ज्यादातर मामलों में, आपके पृष्ठ और इसकी सामग्री को अनुक्रमित नहीं किया जाएगा। हालाँकि, आपको यह ध्यान रखना चाहिए कि खोज इंजन अभी भी पृष्ठ को अन्य पृष्ठों से सूचना और लिंक के आधार पर अनुक्रमित करने में सक्षम हैं।

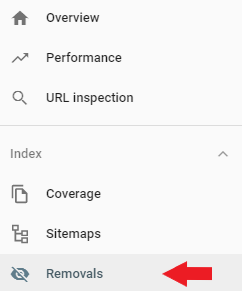

- Search Console Remove URL टूल: यह वैकल्पिक रूट पूरी तरह से अनुक्रमण समस्या को हल नहीं करता है, क्योंकि Search Console Remove URL टूल सीमित समय के लिए पृष्ठ को SERPs से हटा देता है।

हालाँकि, इससे आपको SERPs से पूर्ण पृष्ठों को हटाने के लिए आगे रोबोट नियम और टैग तैयार करने के लिए पर्याप्त समय मिल सकता है।

आप Google खोज कंसोल पर मुख्य नेविगेशन के बाईं ओर स्थित URL निकालें टूल पा सकते हैं।

नोइंडेक्स बनाम डिस्लो

आप में से बहुत से लोग शायद आश्चर्य करते हैं कि क्या यह नोइंडेक्स टैग का उपयोग करना बेहतर है या आपकी robots.txt फ़ाइल में नियम को अस्वीकार करना है। हम पहले से ही पिछले हिस्से में कवर कर चुके हैं कि क्यों noindex नियम अब robots.txt और विभिन्न विकल्पों में समर्थित नहीं है।

यदि आप यह सुनिश्चित करना चाहते हैं कि आपके किसी एक पृष्ठ को खोज इंजन द्वारा अनुक्रमित नहीं किया गया है, तो आपको निश्चित रूप से noindex मेटा टैग देखना चाहिए। यह बॉट्स को पृष्ठ तक पहुंचने की अनुमति देता है, लेकिन टैग रोबोटों को यह बताएगा कि इस पृष्ठ को अनुक्रमित नहीं किया जाना चाहिए और SERPs में दिखाई नहीं देना चाहिए।

अस्वीकृत नियम सामान्य रूप से noindex टैग जितना प्रभावी नहीं हो सकता है। बेशक, इसे robots.txt में जोड़कर, आप अपने पृष्ठ को क्रॉल करने से बॉट्स को रोक रहे हैं, लेकिन यदि उल्लेखित पृष्ठ आंतरिक और बाहरी लिंक द्वारा अन्य पृष्ठों से जुड़ा हुआ है, तो बॉट्स अभी भी अन्य पेजों द्वारा प्रदान की गई जानकारी के आधार पर इस पृष्ठ को अनुक्रमित कर सकते हैं। / वेबसाइटों।

आपको याद रखना चाहिए कि यदि आप पृष्ठ को अस्वीकृत करते हैं और noindex टैग जोड़ते हैं, तो रोबोट आपके noindex टैग को कभी नहीं देख पाएंगे, जो अभी भी SERPs में पृष्ठ की उपस्थिति का कारण बन सकता है।

रेगुलर एक्सप्रेशंस एंड वाइल्डकार्ड्स का उपयोग करना

ठीक है, तो अब हम जानते हैं कि robots.txt फ़ाइल क्या है और इसका उपयोग कैसे करना है, लेकिन आप सोच सकते हैं, “मेरे पास एक बड़ी ईकामर्स वेबसाइट है, और मैं उन सभी पृष्ठों को अस्वीकार करना चाहूंगा जिनमें उनके URL में प्रश्न चिह्न (?) हैं। । "

यह वह जगह है जहां हम आपके वाइल्डकार्ड को पेश करना चाहते हैं, जिसे robots.txt के भीतर लागू किया जा सकता है। वर्तमान में, आपके पास चुनने के लिए दो प्रकार के वाइल्डकार्ड हैं।

- * वाइल्डकार्ड्स - जहां * वाइल्डकार्ड वर्ण आपके इच्छित वर्ण के किसी भी क्रम से मेल खाएंगे। इस प्रकार का वाइल्डकार्ड आपके URL के लिए एक शानदार समाधान होगा जो समान पैटर्न का अनुसरण करता है। उदाहरण के लिए, आप उन सभी फ़िल्टर पृष्ठों को क्रॉल करने से रोक सकते हैं जिनमें उनके URL में एक प्रश्न चिह्न (?) शामिल है।

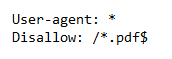

- $ वाइल्डकार्ड - जहां $ आपके URL के अंत से मेल खाएगा। उदाहरण के लिए, यदि आप यह सुनिश्चित करना चाहते हैं कि आपकी रोबोट फ़ाइल सभी पीडीएफ फाइलों तक पहुँचने से बॉट को रोक रही है, तो आप नियम जोड़ना चाह सकते हैं, जैसे नीचे प्रस्तुत किया गया है:

चलो जल्दी से ऊपर के उदाहरण को तोड़ते हैं। आपका robots.txt किसी भी उपयोगकर्ता-एजेंट बॉट को आपकी वेबसाइट को क्रॉल करने की अनुमति देता है, लेकिन यह उन सभी पृष्ठों तक पहुंच को रोक देता है जिनमें .pdf अंत होता है।

बचने की गलतियाँ

हमने उन चीजों के बारे में थोड़ी बात की है जो आप कर सकते हैं और विभिन्न तरीके जिनसे आप अपने robots.txt को संचालित कर सकते हैं। हम इस खंड में प्रत्येक बिंदु पर थोड़ी गहराई से जा रहे हैं और समझाते हैं कि कैसे प्रत्येक का उपयोग एसईओ आपदा में बदल सकता है यदि इसका ठीक से उपयोग न किया जाए।

अच्छी सामग्री को अवरुद्ध न करें

किसी भी अच्छी सामग्री को ब्लॉक करना महत्वपूर्ण नहीं है जिसे आप robots.txt फ़ाइल या नोइंडेक्स टैग द्वारा प्रचार के लिए प्रस्तुत करना चाहते हैं। हमने पिछली कई गलतियों को इस तरह से देखा है, जिससे एसईओ परिणाम को नुकसान पहुंचा है। आपको नोइंडेक्स टैग के लिए अपने पृष्ठों को अच्छी तरह से जांचना चाहिए और नियमों को अस्वीकार करना चाहिए।

क्रॉल-देरी का अति प्रयोग

हमने पहले ही बता दिया है कि क्रॉल-विलंब निर्देश क्या करता है, लेकिन आपको इसे अक्सर उपयोग करने से बचना चाहिए क्योंकि आप बॉट्स द्वारा क्रॉल किए गए पृष्ठों को सीमित कर रहे हैं। यह कुछ वेबसाइटों के लिए एकदम सही हो सकता है, लेकिन अगर आपको एक बड़ी वेबसाइट मिल गई है, तो आप अपने आप को पैर में गोली मार सकते हैं और अच्छी रैंकिंग और ठोस यातायात को रोक सकते हैं।

मामले की संवेदनशीलता

Robots.txt फ़ाइल संवेदनशील है, इसलिए आपको सही तरीके से रोबोट फ़ाइल बनाना याद रखना होगा। आपको रोबोट फाइल को 'robots.txt' के रूप में कॉल करना चाहिए, सभी निचले मामलों के साथ। अन्यथा, यह काम नहीं करेगा!

सामग्री अनुक्रमण को रोकने के लिए Robots.txt का उपयोग करना

हमने इसे पहले ही थोड़ा कवर कर दिया है। किसी पृष्ठ को अस्वीकृत करना बॉट्स को सीधे क्रॉल करने की कोशिश करने और रोकने का सबसे अच्छा तरीका है।

लेकिन यह निम्नलिखित परिस्थितियों में काम नहीं करेगा:

- यदि पृष्ठ किसी बाहरी स्रोत से लिंक किया गया है, तो बॉट अभी भी पृष्ठ के माध्यम से प्रवाह और अनुक्रमण करेगा।

- अवैध बॉट अभी भी सामग्री को क्रॉल और अनुक्रमित करेंगे।

निजी सामग्री को Shield.txt का उपयोग करना

कुछ निजी सामग्री जैसे PDF या थैंक्यू पेज इंडेक्सेबल होते हैं, भले ही आप बॉट को इससे दूर रखें। अस्वीकृत निर्देश के साथ जाने के सर्वोत्तम तरीकों में से एक आपके सभी निजी सामग्री को लॉगिन के पीछे रखना है।

बेशक, इसका मतलब यह है कि यह आपके आगंतुकों के लिए एक और कदम जोड़ता है, लेकिन आपकी सामग्री सुरक्षित रहेगी।

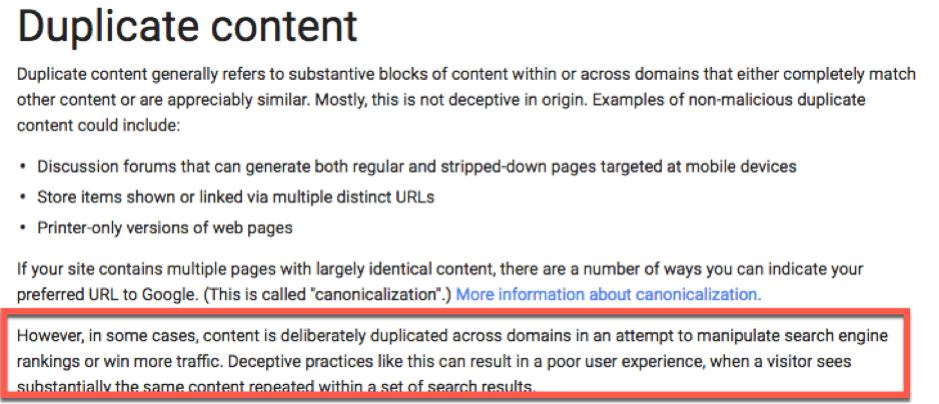

दुर्भावनापूर्ण डुप्लिकेट सामग्री को छिपाने के लिए Robots.txt का उपयोग करना

उदाहरण के लिए, डुप्लिकेट सामग्री कभी-कभी एक आवश्यक बुराई होती है - प्रिंटर के अनुकूल पृष्ठ सोचें।

हालाँकि, Google और अन्य खोज इंजन यह जानने के लिए पर्याप्त स्मार्ट हैं कि आप कब कुछ छिपाने की कोशिश कर रहे हैं। वास्तव में, ऐसा करना वास्तव में इस पर अधिक ध्यान आकर्षित कर सकता है, और ऐसा इसलिए है क्योंकि Google एक प्रिंटर अनुकूल पृष्ठ और किसी व्यक्ति के बीच अंतर को पहचानने की कोशिश कर रहा है, जो उनकी आंखों पर ऊन खींचने की कोशिश कर रहा है:

अभी भी एक मौका है यह वैसे भी पाया जा सकता है।

इस प्रकार की सामग्री से निपटने के तीन तरीके इस प्रकार हैं:

- सामग्री को फिर से लिखना - रोमांचक और उपयोगी सामग्री बनाना आपकी वेबसाइट को एक विश्वसनीय स्रोत के रूप में देखने के लिए खोज इंजन को प्रोत्साहित करेगा। यह सुझाव विशेष रूप से प्रासंगिक है यदि सामग्री एक कॉपी और पेस्ट नौकरी है।

- 301 पुनर्निर्देशित - 301 पुनर्निर्देशन खोज इंजन को सूचित करता है कि एक पृष्ठ दूसरे स्थान पर स्थानांतरित हो गया है। डुप्लिकेट सामग्री के साथ एक पृष्ठ पर 301 जोड़ें और आगंतुकों को साइट पर मूल सामग्री को डायवर्ट करें।

- Rel = "कैनोनिकल - यह एक टैग है जो Google को डुप्लिकेट सामग्री के मूल स्थान की सूचना देता है ; यह विशेष रूप से एक ई-कॉमर्स वेबसाइट के लिए महत्वपूर्ण है जहां सीएमएस अक्सर एक ही यूआरएल के डुप्लिकेट संस्करण उत्पन्न करता है।

सच्चाई का क्षण: अपने रोबोट से बाहर की जाँच करें

अब आपकी फ़ाइल का परीक्षण करने का समय है यह सुनिश्चित करने के लिए कि आप जिस तरीके से चाहते हैं वह सब कुछ काम कर रहा है।

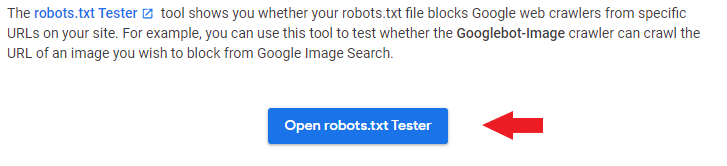

Google के वेबमास्टर टूल्स में robots.txt परीक्षण अनुभाग है, लेकिन यह वर्तमान में केवल Google खोज कंसोल के पुराने संस्करण में उपलब्ध है। अब आप जीएससी के एक अद्यतन संस्करण का उपयोग करके रोबोट.टेक्स परीक्षक का उपयोग नहीं कर पाएंगे (जीएससी में नई सुविधाओं को जोड़ने पर Google कड़ी मेहनत कर रहा है, इसलिए शायद भविष्य में हम Robots.txt परीक्षक को देख पाएंगे। मुख्य नेविगेशन)।

तो सबसे पहले, आपको Google सहायता पृष्ठ पर जाना होगा , जो यह बताता है कि Robots.txt परीक्षक क्या कर सकता है।

वहां आपको robots.txt परीक्षक उपकरण भी मिलेगा:

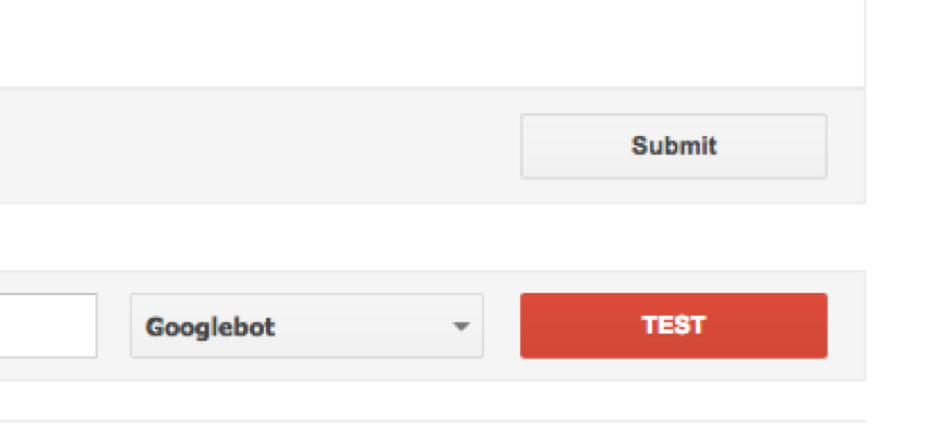

उस संपत्ति को चुनें जिस पर आप काम करने जा रहे हैं - उदाहरण के लिए, ड्रॉपडाउन सूची से आपकी व्यावसायिक वेबसाइट।

वर्तमान में बॉक्स में कुछ भी निकालें, इसे अपनी नई robots.txt फ़ाइल से बदलें और क्लिक करें, परीक्षण करें:

तो करने के लिए 'टेस्ट' परिवर्तन 'अनुमति' है, तो आप अपने आप को एक पूरी तरह से कार्य कर रहा मिला robots.txt ।

अपनी robots.txt फ़ाइल को सही तरीके से बनाना, इसका मतलब है कि आप अपने एसईओ और अपने आगंतुकों के उपयोगकर्ता अनुभव में सुधार कर रहे हैं।

बॉट्स को सही चीजों को क्रॉल करने के लिए अपने दिन बिताने की अनुमति देने से, वे आपकी सामग्री को उस तरह से व्यवस्थित और दिखाने में सक्षम होंगे जैसे आप इसे SERPs में देखना चाहते हैं।

सीएमएस प्लेटफार्मों के लिए संसाधन कैसे करें

- वर्डप्रेस रोबोट

- मैगेंटो रोबोट

- Shopify Robots.txt

- Wix Rob.txt

- जूमला! robots.txt

No comments:

Post a Comment